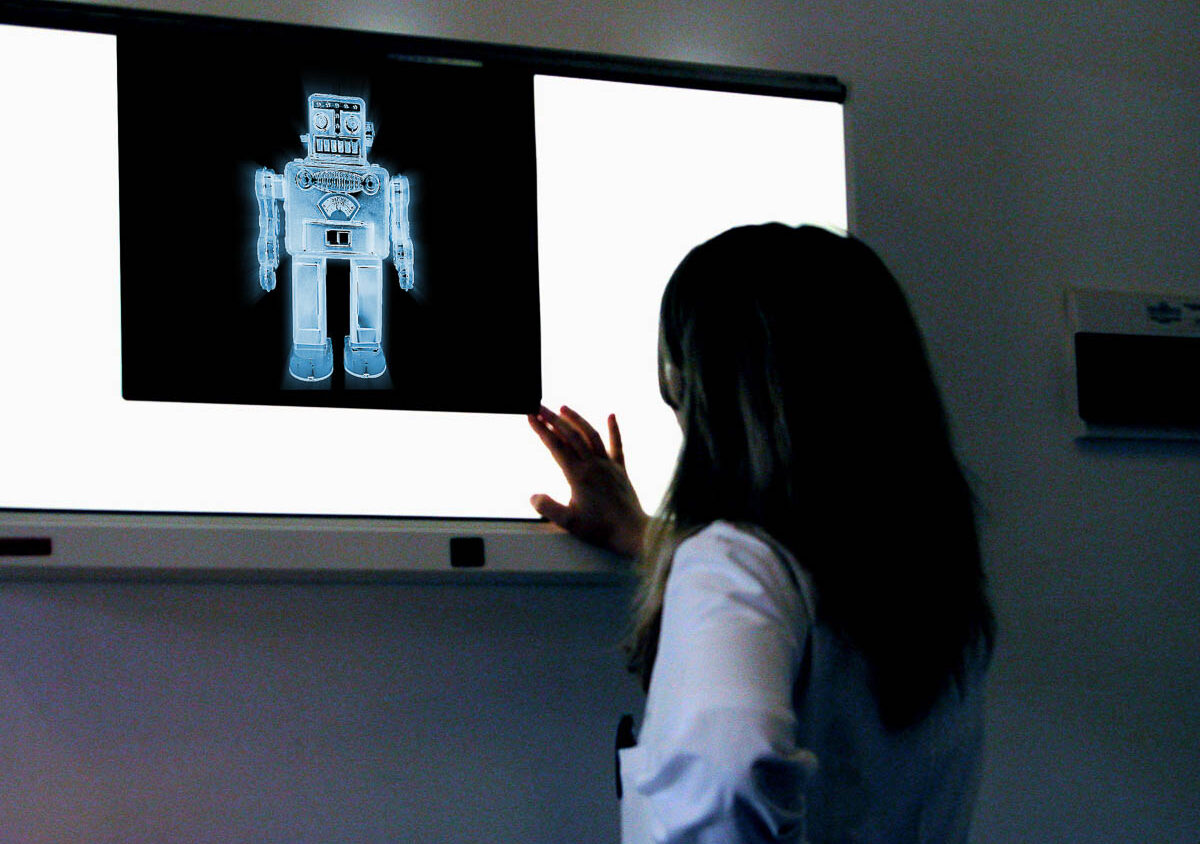

Alors que les outils d’aide au diagnostic basés sur l’apprentissage profond (deep learning) commencent à s’installer dans les services et les cabinets, des chercheurs britanniques en ophtalmologie ont voulu faire le point sur leurs performances par rapport à celles des professionnels de santé. Dans le même temps, ils ont évalué la qualité des études qui analysent ces performances. « Les annonces de développement de modèles capables d’égaler ou de surpasser les performances diagnostiques des humains ont généré une excitation considérable, mais cet enthousiasme ne doit pas faire oublier le besoin d’évaluation critique », écrivent-ils dans la revue The Lancet Digital Health [1].

25 études incluses

Pour cette méta-analyse, qu’ils présentent comme la première du genre, ils ont sondé les bases Ovid-MELINE, Embase, Science Citation Index et Conference Proceedings à la recherche de tous les articles parus de janvier 2012 au 6 juin 2019 qui comparent les performances diagnostiques des algorithmes

Discussion

Aucun commentaire

Commenter cet article