Aide à la décision

La façon dont l’IA justifie ses résultats influencerait les performances diagnostiques du médecin

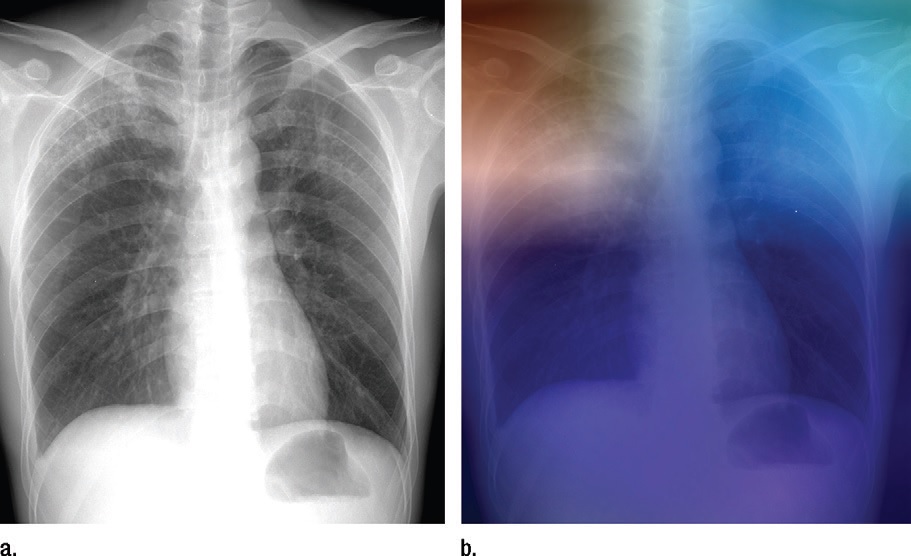

Une étude a comparé les performances diagnostiques de médecins assistés par l’IA en fonction du niveau d’exactitude et de la façon dont le l’outil justifiait ses prédictions. Leur précision était supérieure quand l’outil décrivait les données qui avaient guidé son raisonnement.

Quand le conseil de l’IA était correct, la précision diagnostique des médecins était de 92,8 % (± 0.62) avec une explication locale et de 85,3 % (± 0.85) avec une explication globale (photo d'illsutration). D. R.

Il vous reste 75% de l’article à lire

Docteur Imago réserve cet article à ses abonnés

Vous avez déjà un compte ? Se connecter

- Tous les contenus « abonnés » en illimité

- Le journal numérique en avant-première

- Newsletters exclusives, club abonnés

Abonnez-vous !

Docteur Imago en illimité sur desktop, tablette, smartphone, une offre 100% numérique

23 €

par mois

Auteurs

Bibliographie

Discussion

Aucun commentaire

Commenter cet article