Évaluation de l'IA

Un nouveau cadre d’évaluation proposé pour juger de la valeur ajoutée d’une IA en radiologie

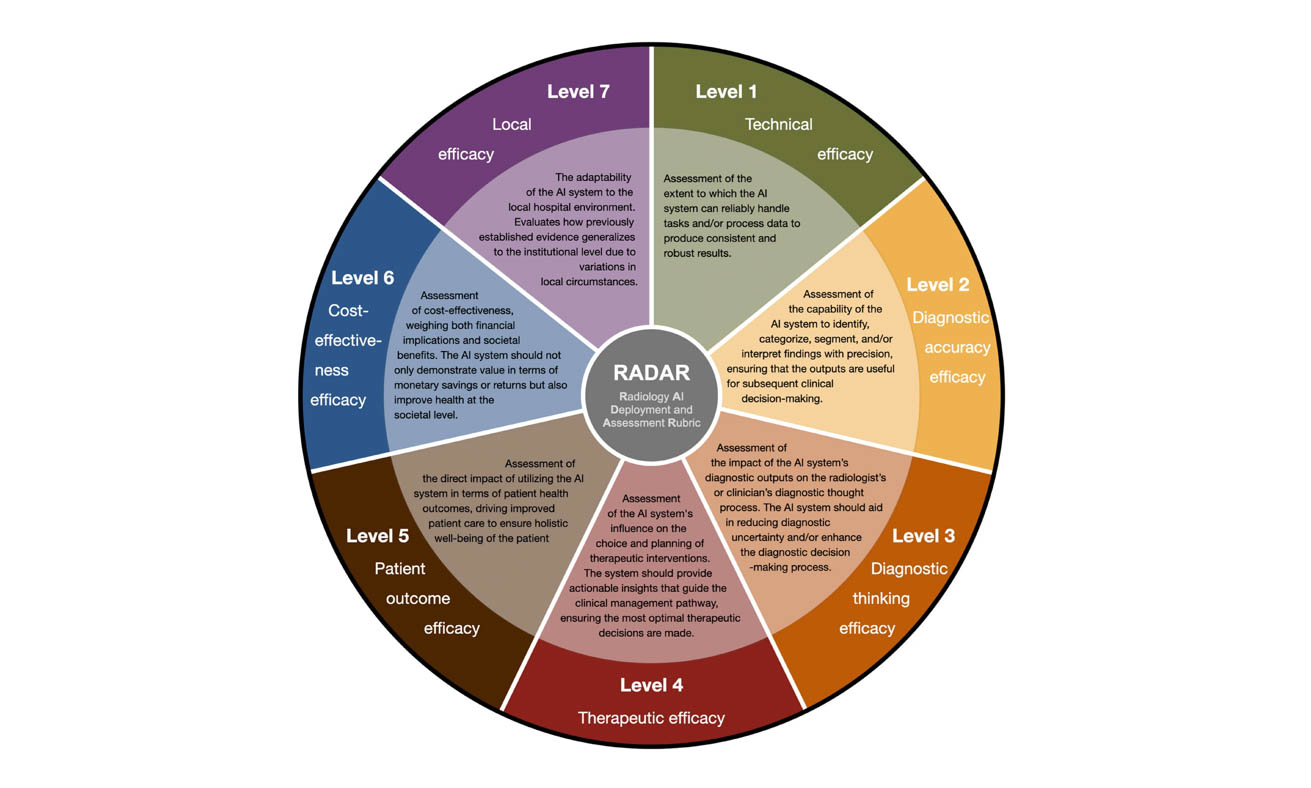

Basé sur une évaluation en sept niveaux, le nouveau cadre d'évaluation RADAR s'inspire du modèle hiérarchique de Fryback et Thornsbury d'évaluation de l'efficacité des examens d'imagerie diagnostique. © Boverhof et al, Insights into Imaging | CC BY 4.0 DEED

À l'heure de la démocratisation de l'intelligence artificielle (IA) en médecine, l'évaluation de la valeur ajoutée apportée à la radiologie par ces logiciels paraît critique pour permettre leur adoption locale en clinique par les praticiens. Dans cette optique, une équipe de sept médecins néerlandais et anglais, dont trois radiologues, a publié le 5 février 2024 une déclaration décrivant un nouveau cadre d'évaluation de l'IA intitulé Radiology AI deployment and assessment rubric (RADAR) [1].

Il vous reste 50% de l’article à lire

Docteur Imago réserve cet article à ses abonnés

Vous avez déjà un compte ? Se connecter

- Tous les contenus « abonnés » en illimité

- Le journal numérique en avant-première

- Newsletters exclusives, club abonnés

Abonnez-vous !

Docteur Imago en illimité sur desktop, tablette, smartphone, une offre 100% numérique

Offre mensuelle 100 % numérique

S’abonner à Docteur Imago

23 €

par mois

Auteurs

Bibliographie

- Boverhof B.-J., Redekop W. K., Bos D. et al, « Radiology AI Deployment and Assessment Rubric (RADAR) to bring value-based AI into radiological practice », Insights into Imaging, 5 février 2024. DOI : 10.1186/s13244-023-01599-z.

- Fryback D. G., Thornbury J. R., « The Efficacy of Diagnostic Imaging », Medical Decision Making, juin 1991. DOI : 10.1177/0272989X9101100203.

- Guenoun D., Zins M., Champsaur P. et al, « French community grid for the evaluation of radiological artificial intelligence solutions (DRIM France Artificial Intelligence Initiative) », Diagnostic and Interventional Imaging, 23 septembre 2023. DOI : 10.1016/j.diii.2023.09.002.

Discussion

Aucun commentaire

Commenter cet article