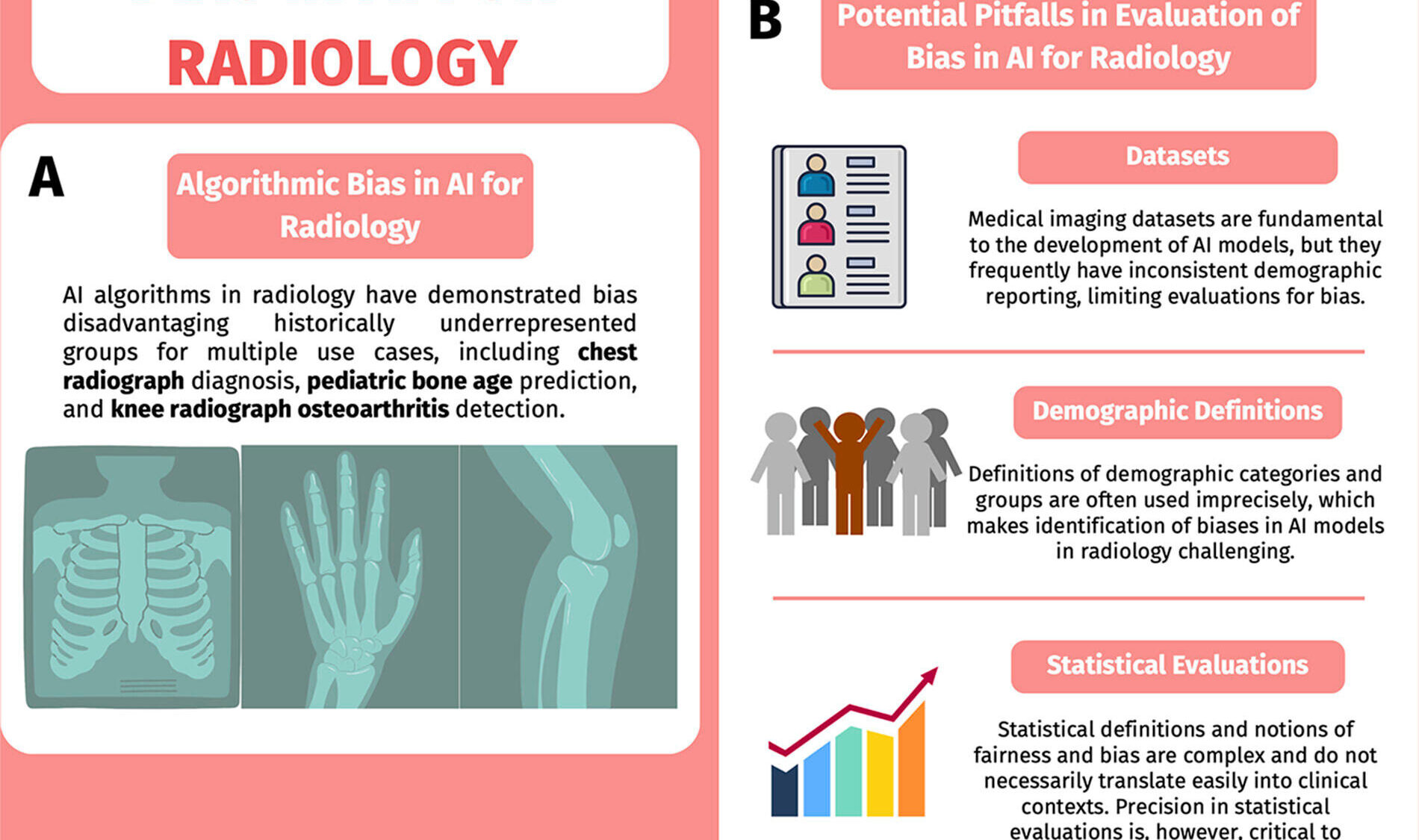

Alors que les outils d’IA sont de plus en plus utilisés en radiologie, avec des applications allant du diagnostic automatisé de maladies complexes, au triage des urgences, et à l’extraction automatisée d’informations sur les résultats des patients à partir de rapports en texte libre, une étude américaine publiée dans la revue Radiology [1] constate néanmoins une persistance des iniquités dans le diagnostic et les soins.

L’IA défavorise certains groupes

Selon les chercheurs, les modèles d’IA peuvent présenter des biais qui défavorisent certains groupes de patients, notamment ceux issus de populations historiquement sous-représentées. Pourtant malgré une meilleure prise de conscience de ces iniquités, l’évaluation des biais algorithmiques, ou biais de l’IA, reste difficile, indique l’étude.

Ensembles de données incomplets

Les auteurs américains identifient trois facteurs contribuant à ces biais parmi lesquels des ensembles de données d’imagerie médicale incomplets comportant de manière limit

Discussion

Aucun commentaire

Commenter cet article